Gli attacchi informatici dell’intelligenza artificiale sono una “minaccia critica”. Ecco come contrastarli secondo la NATO e che effetto avranno sulla società, i social media.

Gli strumenti e gli algoritmi di intelligenza artificiale possono aiutare a rilevare e respingere le minacce informatiche, ma possono anche essere utilizzati dagli hacker nei loro attacchi informatici.

L’intelligenza artificiale (AI) sta giocando un ruolo massiccio negli attacchi informatici e si sta rivelando un'”arma a doppio taglio” e una “sfida enorme”, secondo la NATO.

“L’intelligenza artificiale consente ai difensori di scansionare le reti in modo più automatico e di respingere gli attacchi piuttosto che farlo manualmente.

Ma anche il contrario, ovviamente, è lo stesso gioco”, ha dichiarato ai giornalisti David van Weel, segretario generale aggiunto della NATO per le sfide emergenti alla sicurezza.

Gli attacchi informatici, sia alle infrastrutture nazionali che alle aziende private, sono aumentati esponenzialmente e sono diventati un punto focale dopo la guerra in Ucraina. Quest’anno la NATO ha dichiarato che un attacco informatico a uno qualsiasi dei suoi Stati membri potrebbe far scattare l’articolo 5, ovvero che un attacco a un membro è considerato un attacco a tutti loro e potrebbe innescare una risposta collettiva.

Gli strumenti basati sull’intelligenza artificiale possono essere utilizzati per individuare e proteggere meglio dalle minacce, ma d’altro canto i criminali informatici possono utilizzare la tecnologia per attacchi più sporadici e più difficili da difendere perché sono numerosi e simultanei.

“L’intelligenza artificiale può essere utilizzata per cercare di penetrare nelle reti utilizzando credenziali e algoritmi per crackare i sistemi”, ha affermato van Weel.

Cercare di risolvere le combinazioni “è una sfida enorme“, ha detto, aggiungendo che “naturalmente vogliamo essere utenti etici dell’IA“.

Ha detto che l’IA sarà usata per la difesa “ma non possiamo garantire che i nostri avversari, che sono quelli che cercano di entrare, usino l’IA nello stesso modo etico”. “È un aspetto di cui dobbiamo tenere conto nella nostra difesa. È sicuramente qualcosa che stiamo osservando”.

La difesa informatica messa alla prova

Il modo in cui difendersi dagli attacchi informatici dell’IA è in fase di sperimentazione nella capitale estone Tallinn, presso il CR14 NATO Cyber Range.

I comandanti delle forze armate di oltre 30 Paesi (non tutti membri della NATO) si sono recati al poligono cibernetico per mettere alla prova le loro capacità di difesa del Paese in collaborazione con i loro alleati.

“Nell’esperimento sull’IA, la strada è fondamentalmente a doppio senso. Si tratta di riconoscere l’IA utilizzata dagli avversari e, dall’altro lato, di esplorare come l’IA possa supportare le nostre operazioni”, ha dichiarato Bernd Hansen, capo sezione del Cyberspazio presso il Comando alleato per la trasformazione della NATO. “Esponiamo gli esperimenti tecnici alla comunità operativa per garantire che ciò che cerchiamo di sviluppare da una prospettiva tecnica serva effettivamente all’operatore, in modo da non marciare a sinistra quando loro vorrebbero che marciassimo a destra”, ha dichiarato a Euronews Next.

Le esercitazioni hanno aiutato i partecipanti, ma c’è ancora molta strada da fare per contrastare la minaccia. L’intelligenza artificiale è “sicuramente un problema serio che credo la comunità informatica stia affrontando”, ha dichiarato Candace Sanchez, capo progettista esecutivo degli Stati Uniti che ha partecipato alle esercitazioni informatiche. “Ma credo che ci vorrà del tempo per cercare di contrastare davvero questa minaccia. Quindi, lavorare insieme in questi sforzi per cercare di farlo, penso che ci aiuterà a progredire”, ha detto a Euronews Next.

Il prezzo della libertà di Internet: come possono essere utilizzati gli attacchi

Gli attacchi informatici dell’Intelligenza Artificiale possono essere utilizzati non solo per bloccare le infrastrutture, ma anche per sfruttare le informazioni.

Il numero di attacchi sta aumentando in modo esponenziale e al momento il mondo sta semplicemente “convivendo con questi attacchi” e ha bisogno di più regole di sicurezza informatica. “Non siamo ancora in una fase in cui ci rendiamo conto che questo non è semplicemente accettabile. Questo dimostra che non abbiamo ancora un approccio collettivo comune per reagire a queste cose, che sono semplicemente inaccettabili”. Sebbene si stia lavorando a soluzioni per affrontare gli attacchi informatici di IA, Domingo ha affermato che non possiamo fermarli se vogliamo che Internet sia ancora un luogo di libero pensiero e indipendenza.

“Abbiamo creato il cyberspazio in un modo aperto a tutti. È un ambiente per sviluppare idee. Questo è ciò che vogliamo. Vogliamo la libertà nel cyberspazio”, ha detto, aggiungendo che smettere di farlo per limitare ciò che possiamo fare su Internet ha un costo troppo alto.

“Il prezzo che dobbiamo pagare per questo [la libertà di Internet] è essere realistici e accettare che ci saranno attacchi nelle reti”, ha detto.

L’unico modo per farvi fronte è utilizzare tutti i meccanismi e tutte le tecnologie incluse per proteggere, ma anche per reagire e recuperare da questi attacchi.

Informatica quantistica

Nel dicembre 2022 gli Stati Uniti hanno approvato il Quantum Computing Cybersecurity Preparedness Act, codificando in legge una misura volta a garantire i sistemi e i dati del governo federale contro i cyberattacchi abilitati dai quanti, che molti prevedono avverranno con la maturazione dell’informatica quantistica.

Alcuni mesi dopo, nel giugno 2023, l’European Policy Centre ha sollecitato un’azione simile, invitando i funzionari europei a prepararsi all’avvento dei cyberattacchi quantistici, un evento anticipato soprannominato Q-Day.

Secondo gli esperti, il lavoro sull’informatica quantistica potrebbe progredire abbastanza nei prossimi cinque-dieci anni da raggiungere la capacità di rompere gli attuali algoritmi crittografici – una capacità che potrebbe rendere tutte le informazioni digitali protette dagli attuali protocolli di crittografia vulnerabili ai cyberattacchi.

“Sappiamo che l’informatica quantistica ci colpirà tra tre o dieci anni, ma nessuno sa ancora quale sarà il suo impatto”, afferma Ruchie. Peggio ancora, secondo Ruchie, i malintenzionati potrebbero usare l’informatica quantistica o l’informatica quantistica abbinata all’IA per “creare nuove minacce”.

Cosa possiamo fare al riguardo

L’intelligenza artificiale generativa (AI) è stata sotto i riflettori negli ultimi tempi. Il chatbot ChatGPT e altri sistemi di elaborazione del linguaggio naturale come VALL-E hanno portato l’IA generativa al grande pubblico e ne hanno svelato i benefici e gli effetti negativi.

Una delle preoccupazioni principali dell’IA generativa è il fatto che possa essere utilizzata per aggiornare gli exploit dannosi e per elaborare cyberattacchi più sofisticati. In che modo gli hacker utilizzano l’IA generativa nei loro attacchi e cosa significa questo per il futuro della sicurezza informatica?

Cos’è l’IA generativa e come funziona?

Come suggerisce il nome, l’IA generativa è un tipo di IA in grado di generare nuovi contenuti: immagini, testi, audio e dati sintetici.

Un esempio famoso è ChatGPT, un chatbot alimentato dall’intelligenza artificiale con il quale è possibile avere conversazioni simili a quelle umane e ricevere ottimi consigli sui film, sempre che non si riesca a pensare a una missione più significativa da inviare a ChatGPT.

E’ in grado di scrivere tutte quelle e-mail difficili, utilizzare ChatGPT come strumento di traduzione e può persino trasformarsi nel vostro assistente per la pianificazione di pasti salutari. Tutto sommato, in pochi secondi, questo chatbot è in grado di proporre contenuti apparentemente nuovi e convincenti e di presentarli in modo politicamente corretto.

Tuttavia, un’intelligenza artificiale generativa non può ancora essere creativa come un essere umano. Questo perché utilizza algoritmi di apprendimento automatico non supervisionati e semi-supervisionati per elaborare una grande quantità di dati e generare risultati personalizzati.

Per esempio, se si desidera commissionare un dipinto simile a Picasso a un’intelligenza artificiale generativa come DALL-E 2, si dovrà digitare la descrizione in un campo designato – diciamo “Guernica di Picasso ma con i gattini” – e attendere un paio di secondi. In questo lasso di tempo, l’intelligenza artificiale applicherà tutti i tratti specifici dello stile dell’artista che ha appreso in precedenza, aggiungerà i gattini per buona misura, e ne verrà fuori qualcosa di originale: l’immagine che si vede poco sopra.

Come gli hacker utilizzano l’intelligenza artificiale generativa nei loro attacchi?

I malintenzionati sono sempre stati attratti dai buoni algoritmi. Non sorprende quindi che sfruttino l’intelligenza artificiale generativa per potenziare i loro attacchi. Utilizzando metodi di ML come l’apprendimento per rinforzo e le reti generative avversarie, i criminali informatici possono ideare nuovi e più sofisticati attacchi informatici in grado di superare le difese informatiche standard.

Un esempio di questa perversione è il chatbot “all’avanguardia” di OpenAI, ChatGPT, sfruttato dai criminali informatici per scrivere malware.

All’inizio, ChatGPT sembrava un gioco divertente, ma ora è diventato una delle principali minacce alla sicurezza e alla privacy. Se vi piace chattare con ChatGPT, è bene che facciate attenzione a ciò che i criminali informatici potrebbero fare con ChatGPT.

In breve, ChatGPT e altri strumenti di intelligenza artificiale generativa hanno reso la vita più facile ai criminali informatici e più difficile ai team di sicurezza.

Alcuni dei modi in cui gli attori delle minacce informatiche utilizzano l’IA nei loro attacchi sono:

- creare malware migliori e più sofisticati: nelle mani degli hacker, l’IA generativa può essere utilizzata per generare ceppi di malware difficili da individuare ed eseguire attacchi. Combinato con modelli di IA, il malware potrebbe mascherare le sue intenzioni fino a raggiungere il suo scopo malvagio.

- Scrivere e-mail di phishing personalizzate e alimentate dall’intelligenza artificiale: Con l’aiuto dell’intelligenza artificiale generativa, le e-mail di phishing non presentano più i segni rivelatori di una truffa, come l’ortografia, la grammatica e la mancanza di contesto. Inoltre, con l’IA come ChatGPT, gli attori delle minacce possono lanciare attacchi di phishing a velocità e scala senza precedenti.

- Generazione di dati falsi profondi: poiché è in grado di creare imitazioni convincenti di attività umane come la scrittura, il parlato e le immagini, l’IA generativa può essere utilizzata in attività fraudolente come il furto di identità, le frodi finanziarie e la disinformazione.

- Cracking dei CAPTCHA e indovinare le password: utilizzati da siti e reti per eliminare i bot che cercano un accesso non autorizzato, i CAPTCHA possono ora essere aggirati dagli hacker. Utilizzando l’analisi ML, possono anche svolgere altri compiti ripetitivi come l’indovinare le password e gli attacchi brute-force.

- Sabotare il ML nel rilevamento delle minacce informatiche: Se un sistema di sicurezza viene sommerso da troppi falsi positivi, un hacker può coglierlo di sorpresa con un vero attacco informatico.

Come possiamo combattere la minaccia dell’intelligenza artificiale generativa?

Man mano che gli attacchi informatici diventano più sofisticati e le loro conseguenze più gravi, i sistemi di sicurezza tradizionali diventeranno un ricordo dell’epoca passata. Grazie alla capacità di imparare dagli attacchi precedenti e di adattarsi, l’intelligenza artificiale è una risorsa inestimabile sia per i criminali informatici che per i loro avversari.

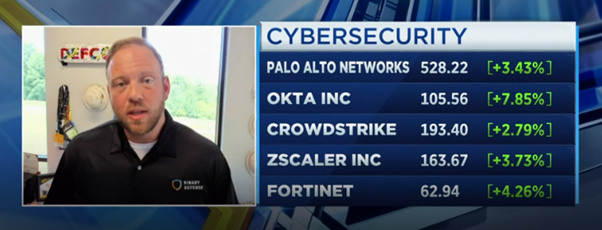

L’uso dell’IA nella sicurezza informatica presenta alcuni vantaggi seri, come una maggiore rapidità di rilevamento, identificazione e risposta alle minacce, per cui combattere il fuoco con il fuoco sembra la risposta giusta. Prima che i criminali informatici imparino a infliggere colpi devastanti a individui e aziende in tutto il mondo, i professionisti della sicurezza informatica devono insegnare ai loro sistemi dotati di intelligenza artificiale a proteggersi da questi attacchi.

Tuttavia, non è tutto nelle mani dell’IA. Dopo tutto, possiamo anche rafforzare la nostra sicurezza e la nostra privacy con metodi collaudati come l’autenticazione a più fattori (MFA), la tecnologia biometrica, l’utilizzo di un password manager, l’uso dei migliori strumenti di collaborazione criptati e il buon vecchio buon senso.

Combattere l’IA con l’IA

Assisteremo a guerre di cybersicurezza contro l’IA nel prossimo futuro?

Speriamo di no. Tuttavia, poiché l’IA continua a progredire e diventa accessibile a tutti – criminali informatici e professionisti della sicurezza informatica – il ruolo dell’IA e del ML diventerà sempre più importante negli anni a venire.

Come l’intelligenza artificiale generativa potrebbe avere un impatto negativo sui social media

L’intelligenza artificiale generativa sta sconvolgendo molti settori. Un settore che potrebbe subire un impatto negativo è quello dei social media.

L’impatto dell’IA generativa sui social media è sottile, ma di ampia portata. Viene già utilizzata per creare nuovi contenuti, come immagini, video e testi, e per curare i contenuti esistenti. Se da un lato questa tecnologia ha il potenziale per avvantaggiare gli utenti dei social media, dall’altro comporta alcuni rischi e svantaggi.

Esaminiamo alcuni di questi modi in cui l’IA generativa potrebbe avere un impatto negativo sui social media e sui suoi utenti

1. Sottrazione di opportunità ai creatori

L’IA generativa semplifica la creazione di contenuti. Ma sembra che la maggior parte della semplificazione riguardi le persone che utilizzano contenuti altrui e non i creatori originali. È probabile che abbiate trovato uno di quei video in cui un guru raccomanda di utilizzare i “contenuti generati dall’IA” per fare soldi. L’idea è che si possa trasformare il lavoro di altri creatori in qualcosa di nuovo, senza tanto sforzo o lavoro.

Questa non è una buona cosa per i creatori, perché svaluta il loro lavoro e rende più facile per altri rubare i loro contenuti.

2. Creazione di contenuti meno originali

Poiché l’intelligenza artificiale generativa consente di creare contenuti con poco sforzo, alcuni potrebbero scegliere questa strada invece di creare qualcosa di unico. Questo potrebbe portare alla creazione e alla condivisione di contenuti omogenei e meno originali sulle piattaforme dei social media.

È già possibile vedere questo fenomeno in alcune delle piattaforme di social media più popolari, con contenuti sempre più simili. Ne sono un esempio i tweet “X può fare Y, ma la maggior parte delle persone non lo sa….” su Twitter.

3. Mancanza di unicità, creazione di camere dell’eco

Un primo effetto collaterale dei contenuti generati dall’IA sui social media è la loro omogeneità. Quando gli strumenti di IA prendono il controllo della creazione di contenuti, il risultato è un’esperienza omogenea sui social media, in cui è più difficile trovare idee e opinioni che si discostino dal mainstream.

Senza prospettive uniche da parte di creatori reali, le piattaforme di social media possono diventare camere dell’eco in cui vengono condivise sempre le stesse idee e opinioni. Si tratta di uno sviluppo pericoloso perché potrebbe portare a un soffocamento della creatività e al rafforzamento di convinzioni di parte.

4. Riduzione della fiducia del pubblico

I social media sono diventati molto più di un luogo dove condividere idee ed esperienze. Sono diventati anche una fonte di informazioni, notizie e consigli. Su una qualsiasi delle piattaforme di social media più diffuse si trovano professionisti di diversi settori che danno consigli e parlano delle loro aree di competenza.

Il problema dei contenuti generati dall’intelligenza artificiale è che possono erodere la fiducia tra il pubblico e le persone che seguono. Come si può essere sicuri che un consiglio provenga da un esperto e non da uno strumento di intelligenza artificiale?

Il pericolo è che le persone possano perdere fiducia nei contenuti provenienti dalle piattaforme di social media e potenzialmente nelle piattaforme stesse.

5. Deepfakes e profili falsi

Oggi, gli strumenti di intelligenza artificiale generativa vengono già utilizzati per creare video deepfake a scopi malevoli. I deepfake potrebbero essere utilizzati per creare profili falsi sulle piattaforme di social media, rendendo più facile per gli attori malintenzionati prosperare sui social media.

I profili falsi rappresentano un rischio significativo, in quanto potrebbero aprire le porte alla criminalità informatica e alle frodi, tra cui le truffe di impersonificazione e il furto di identità.

L’Apocalisse è vicina per i social media?

L’intelligenza artificiale generativa può essere un’arma a doppio taglio, con conseguenze positive e negative per gli utenti dei social media. Potrebbe rivoluzionare il modo in cui creiamo e condividiamo i contenuti sulle piattaforme dei social media, ma comporta anche alcuni rischi e svantaggi.

A questo punto, è difficile sapere come l’IA generativa plasmerà il futuro dei social media. Ma è fondamentale essere consapevoli dei rischi potenziali e pensare a come mitigarli. Solo così i social media potranno essere uno spazio sicuro e positivo per la condivisione di idee ed esperienze.

Leggi anche:

Contributo esterno